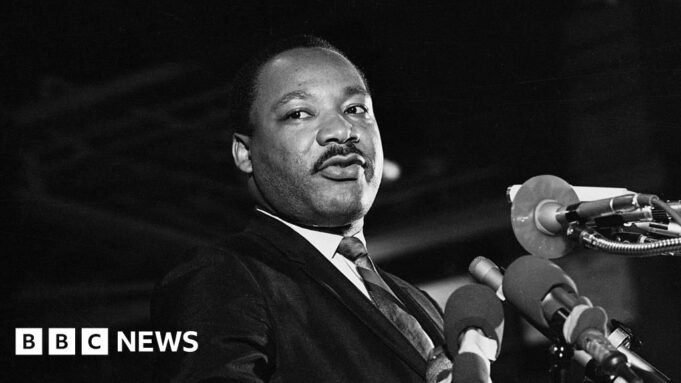

Liv Mc Mahonreportero de tecnología

Archivo Bateman/Getty Images

Archivo Bateman/Getty ImagesOpenAI se ha detenido Su aplicación de inteligencia artificial (IA), Sora, crea vídeos falsos que representan al Dr. Martin Luther King Jr. a petición de sus herederos.

La empresa admitió que el generador de vídeo creó contenido “irrespetuoso” sobre el activista de derechos civiles.

Sora tiene Se ha vuelto viral en EE.UU. Debido a su capacidad para crear vídeos hiperrealistas, ha dado lugar a que se compartan imágenes falsas de celebridades y personajes históricos que han muerto en escenas grotescas y, a menudo, ofensivas.

OpenAI dijo que pausaría las imágenes del Dr. King ya que “fortalece la protección de las figuras históricas”, pero permitirá a las personas crear clips de otras figuras de alto perfil.

Presidente John F. Esa política ha sido controvertida desde que se compartieron ampliamente en línea videos en los que aparecen personas como Kennedy, la reina Isabel II y el profesor Stephen Hawking.

Fue dirigida por Zelda Williams, hija de Robin Williams. Para pedirle a la gente que deje de enviarle videos de su padre generados por IAPopular actor y cómico estadounidense que murió en 2014.

Bernice A. King, hija del difunto Dr. King, hizo más tarde una petición pública similar: Escribir en línea: “Estoy de acuerdo con mi padre. Por favor, detente”.

Algunos de los vídeos generados por IA que muestran al activista de derechos civiles han modificado su infame discurso “Tengo un sueño” de varias maneras. Informes del Washington Post Un clip lo mostró haciendo ruidos racistas.

Mientras tanto, otros, compartidos en la aplicación Sora y en las redes sociales, mostraban figuras del Dr. King y su compañero activista de derechos civiles Malcolm X peleando entre sí.

permitir incógnita ¿Contenido?

La autora y especialista en ética de la IA, Olivia Gambelin, dijo a BBC OpenAI que restringir un mayor uso de la imagen del Dr. King era un “buen paso adelante”.

Pero dijo que la compañía debería haber tomado medidas desde el principio en lugar de adoptar un enfoque de “prueba y error mediante mangueras contra incendios” para implementar dicha tecnología.

Dijo que la capacidad de crear deepfakes de personajes históricos fallecidos no sólo habla de “respeto” por ellos, sino que también plantea más riesgos para la comprensión pública del contenido real y falso.

“Está muy cerca de intentar reescribir aspectos de la historia”, dijo.

‘Intereses de la libertad de expresión’

El auge de los deepfakes (vídeos alterados mediante herramientas de inteligencia artificial u otras tecnologías para mostrar a alguien que no habla ni se comporta) ha alimentado la preocupación de que puedan utilizarse para difundir información errónea, discriminación o abuso.

OpenAI dijo el viernes que si bien cree que existen “fuertes intereses de libertad de expresión al representar personajes históricos”, ellos y sus familias deberían conservar el control sobre sus imágenes.

“Los representantes autorizados o los propietarios de propiedades pueden solicitar que sus imágenes no sean utilizadas en los cameos de Sora”, decía.

El experto en IA productiva, Henri Ajder, dijo que el enfoque, aunque positivo, “plantea preguntas sobre quién será y quién no será protegido de una resurrección sintética”.

“El King’s Estate ha planteado esto legítimamente ante OpenAI, pero muchas personas fallecidas no tienen patrimonios bien conocidos y con buenos recursos que los representen”, dijo.

“En última instancia, creo que queremos evitar una situación en la que, a menos que seamos muy famosos, la sociedad acepte que todos son libres de representarse a sí mismos después de nuestra muerte”.

OpenAI dijo en una declaración a la BBC a principios de octubre que había creado “múltiples capas de protección para evitar abusos”.

Dijo que estaba en diálogo directo con “figuras públicas y propietarios de contenido para recopilar comentarios sobre qué tipo de controles quieren” con miras a reflejar esto en futuros cambios.